GraphRAG with Gradio UI

https://github.com/severian42/GraphRAG-Ollama-UI

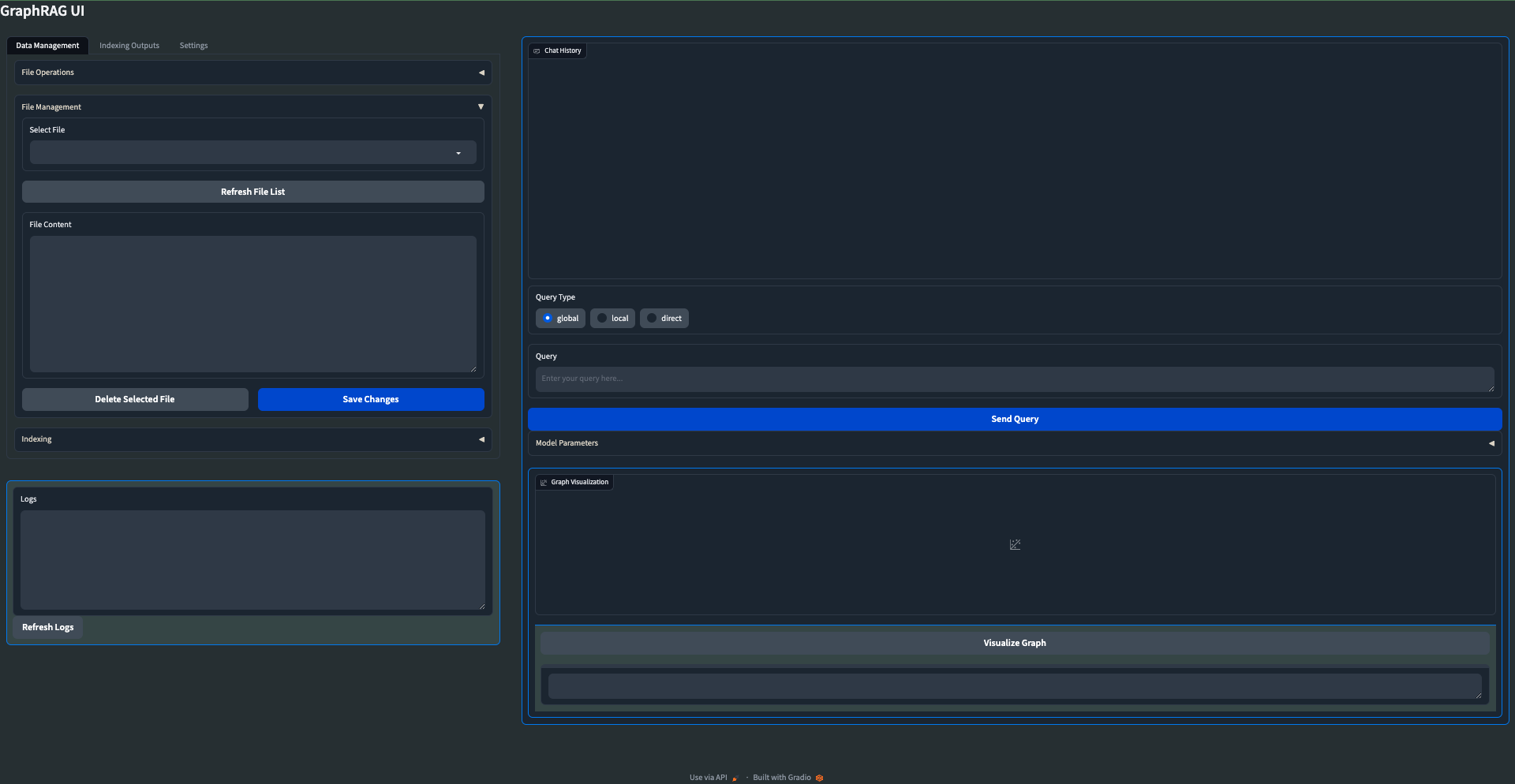

🕸️ 本地 GraphRAG 与 Ollama 和 Gradio UI

欢迎来到 本地 GraphRAG with Ollama 和交互式 UI!这是微软的 GraphRAG 的一个改编版本,旨在支持使用 Ollama 的本地模型,并配备了新的交互式用户界面。

备注

该应用程序比预期获得更多的关注,因此我正在努力修复错误和集成建议的改进。目前它已经可以使用,但您可能会遇到一些问题。这可能意味着如果您不幸发生错误,您可能需要在今天结束前更新您的版本。我会尽量灵活调整这些调整。

目前正在进行的更改:

- 对 LLM 无关:使用 Ollama 或设置自己的基 URL 和本地模型用于 LLM 和嵌入器

- 指数和输出文件生成的错误修复(某些调用中缺少 _final/entities)

- 启动您自己的 GraphRAG API 服务器,以便您可以在自己的外部应用程序中使用这些功能

- Dockerfile 以简化部署

如果您遇到错误,请随时打开一个 Issue,我将尽快解决它,以免造成任何停机时间

📄 研究论文

有关原始 GraphRAG 实现的更多详细信息,请参阅 GraphRAG 论文。

🌟 功能

- 本地模型支持: 利用 Ollama 支持本地 LLM 和嵌入器模型。

- 经济实惠: 消除对昂贵 OpenAI 模型的依赖。

- 交互式 UI: 用户友好的界面,用于管理数据、运行查询和可视化结果。

- 实时图可视化: 使用 Plotly 在 3D 中可视化您的知识图谱。

- 文件管理: 直接从 UI 上传、查看、编辑和删除输入文件。

- 设置管理: 通过 UI 轻松更新和管理您的 GraphRAG 设置。

- 输出探索: 浏览并查看索引输出和元数据。

- 日志记录: 实时日志,以便更好的调试和监控。

📦 安装和设置

按照以下步骤设置和运行 GraphRAG Local with Ollama 和交互式 UI:

-

创建并激活新的 conda 环境:

conda create -n graphrag-ollama -y

conda activate graphrag-ollama -

安装 Ollama: 访问 Ollama 网站 获取安装说明。

-

安装所需的软件包:

pip install -r requirements.txt -

启动交互式 UI:

gradio app.py或

python app.py -

使用 UI:

- 一旦启动了 UI,您就可以通过界面执行所有必要的操作。

- 这包括初始化项目、管理设置、上传文件、运行索引和执行查询。

- 该 UI 提供了一种用户友好的方式来与 GraphRAG 交互,而无需运行命令行操作。

注意:现在 UI 处理了之前通过命令行指令完成的全部操作,使整个过程更加流畅和用户友好。

🛠️ 自定义

用户可以通过在 settings.yaml 文件中更改模型进行实验。LLM 模型期望语言模型(如 llama3、mistral、phi3 等),而嵌入器模型部分期望嵌入模型(如 mxbai-embed-large、nomic-embed-text 等),这些模型由 Ollama 提供。您可以在 Ollama 库中找到提供的完整模型列表。

📊 可视化

UI 现在包括 3D 图形可视化功能。要使用它:

- 在您的数据上运行索引

- 转到“索引输出”标签页

- 选择最新的输出文件夹,并导航到 GraphML 文件

- 点击“可视化图形”按钮